新着記事

大きさも方角も把握「人間の聴覚レベルと同等のコンピュータモデル」

人間の脳は、音の認識だけでなく方向を把握する能力ももっています。

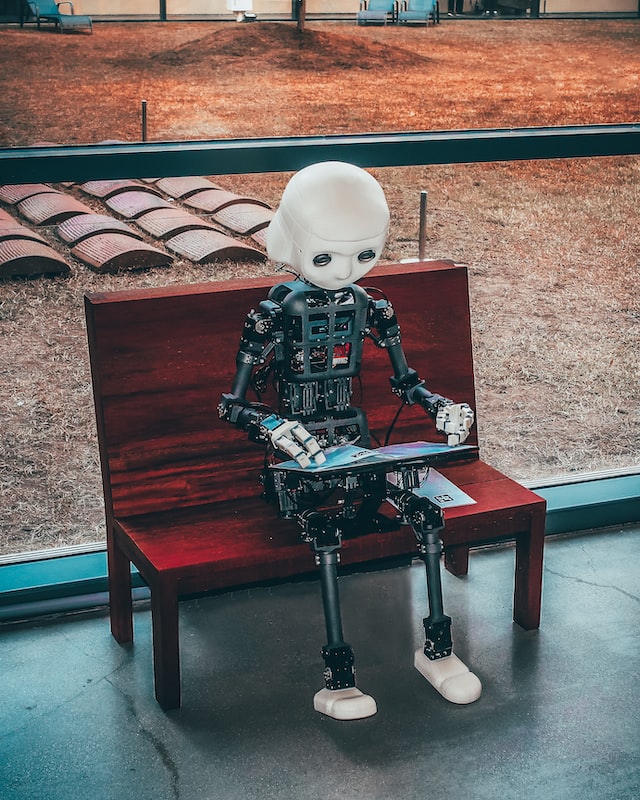

神経学者たちは、人間の脳と同等の聴覚モデルをもつコンピュータモデルを開発しました。

MIT neuroscientists have now developed a computer model that can also perform that complex task.

参照元:https://news.mit.edu/2022/where-sound-come-from-model-0127

– マサチューセッツ工科大学 Massachusetts Institute of Technology. January 27, 2022 –

人間の脳は、特定の音を認識するだけでなく、その音がどの方向から来たのかを判断するために細かく調整されています。

右耳と左耳に届く音の違いを比較することで、脳は吠える犬、泣き叫ぶ消防車、近づいてくる車の位置を推定することができる。

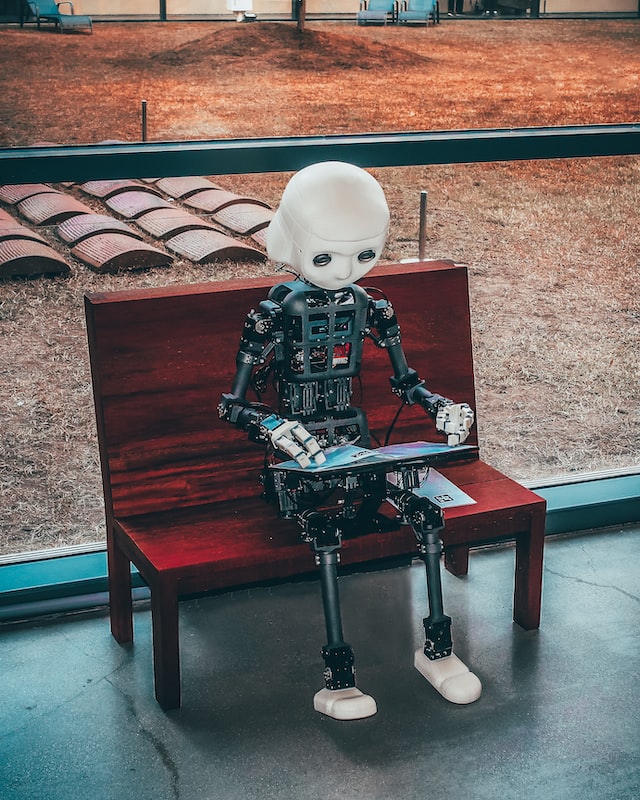

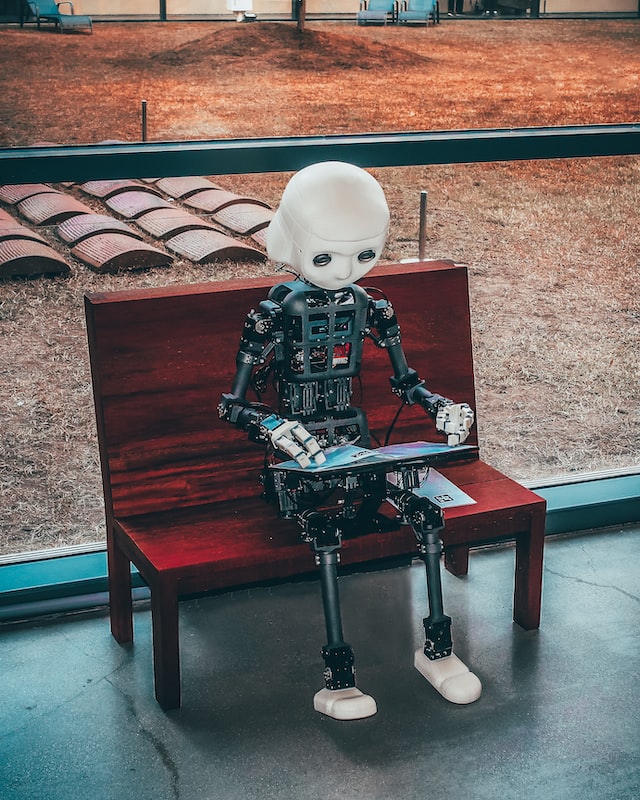

MITの神経科学者たちは、この複雑なタスクを実行できるコンピューターモデルを開発しました。

このモデルは、いくつかの畳み込みニューラルネットワークから構成されており、人間と同じようにタスクをこなすだけでなく、人間と同じように苦労することもあるのです。

MITのMcGovern脳研究所のメンバーである脳認知科学准教授のJosh McDermott氏は話します。

「我々は今、実世界で実際に音を特定できるモデルを手に入れました。そして、このモデルを人間の実験参加者のように扱って、過去に人間が実験した大規模な実験セットをシミュレーションしたところ、何度も何度も分かったことは、このモデルが、人間に見られる結果を再現しているということです。」

この新しい研究からの発見は、人間の位置認識能力が、環境特有の課題に適応していることも示唆していると、MITの脳・心・機械センターのメンバーでもあるMcDermott氏は語っています。

McDermottはこの論文の筆頭著者で、本日『Nature Human Behavior』誌に掲載されました。

この論文の筆頭著者は、MITの大学院生であるアンドリュー・フランクルです。

定位感のモデル化

私たちが汽笛などの音を聞いたとき、その音がどの方向から来るかによって、音波は右耳と左耳に届く時間や強さがわずかに異なります。

このわずかな違いを比較して、音の方向を推定するのが中脳の専門領域で、定位とも呼ばれる作業である。

この作業は、周囲に反響があったり、一度にたくさんの音が聞こえたりするような現実的な環境では、著しく難しくなります。

脳が音の定位に使っているのと同じような計算を行えるコンピューターモデルを作ろうと、科学者たちは長い間研究を続けてきました。

しかし、このようなモデルは、雑音がない理想的な環境ではうまく機能することもあるが、雑音や反響のある現実の環境では決してうまくいきません。

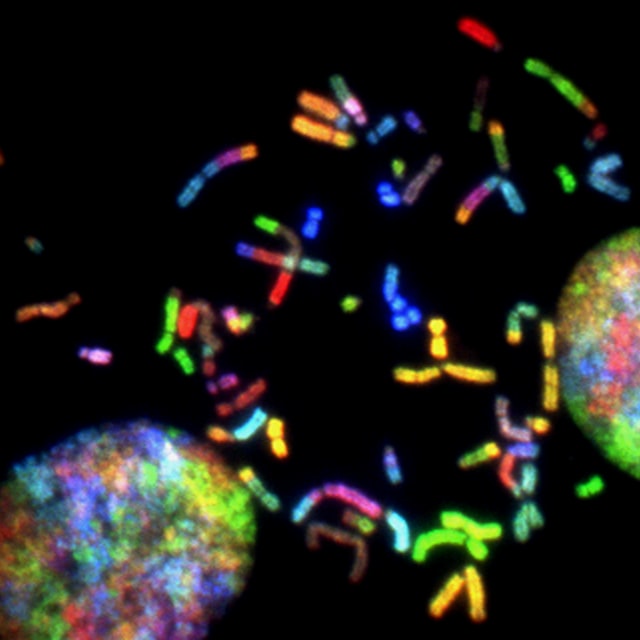

そこでMITの研究チームは、より高度な定位検出モデルを開発するために、畳み込みニューラルネットワークに着目しました。

この種のコンピュータモデリングは、人間の視覚系のモデリングに広く用いられており、最近では、McDermott氏ら科学者が聴覚にも適用し始めています。

畳み込みニューラルネットワークは、さまざまなアーキテクチャで設計できるため、MITの研究チームは、定位に最適なものを見つけるために、スーパーコンピューターを用いて約1,500種類のモデルを訓練し、テストすることができました。

その結果、局在認識に最も適していると思われる10個のモデルが見つかり、研究者たちはそれをさらに訓練して、その後のすべての研究に使用しました。

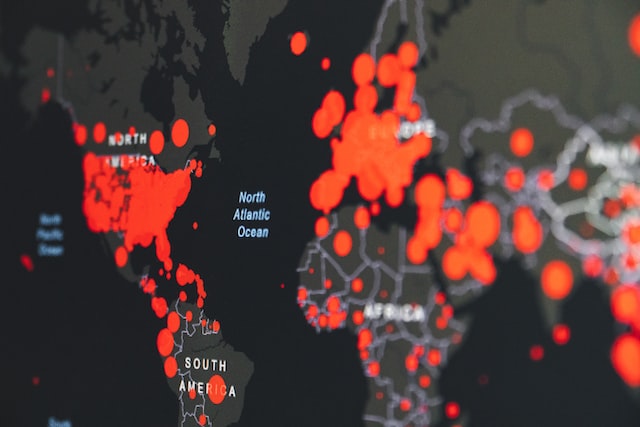

このモデルを訓練するために、研究者たちは、部屋の大きさや部屋の壁の反射特性を制御できる仮想世界を作成した。モデルに入力される音は、すべてこの仮想空間のどこかで発生したものです。

人間の声、動物の声、車のエンジン音などの機械音、雷などの自然音など、400以上の学習用サウンドが用意されました。

また、人間の耳と同じ情報を使って、モデルをスタートさせることも確認しました。

外耳(耳介)には音を反射させるヒダがたくさんあり、耳に入ってくる周波数を変化させますが、この反射は音がどこから入ってくるかによって変化します。

研究者たちは、この効果をシミュレーションするため、コンピューターモデルに取り込む前に、それぞれの音に専用の数学的関数を実行させました。

フランシェル氏は話します。

「これによって、人間が持っているのと同じような情報をモデルに与えることができるのです。」

研究者たちは、モデルを訓練した後、実環境でテストを行いました。

実際の部屋に、耳にマイクをつけたマネキンを置き、さまざまな方向から音を流し、その録音をモデルに送り込んだ。その結果、モデルは人間と同じように音を聞き分けることができました。

フランシェルは続けます。

「モデルは仮想世界で訓練されたものですが、評価したところ、実世界の音を認識することができました。」

類似のパターン

そこで研究者たちは、これまでにも人間の定位能力を研究するために用いられてきた一連のテストを、このモデルにも適用しました。

人間の脳は、右耳と左耳への到達時間の違いを分析するほか、それぞれの耳に到達する音の強さの違いも位置判断の基準にしているそうです。

これまでの研究で、この2つの戦略の成功率は、入ってくる音の周波数によって異なることが分かっています。

今回の研究で、MITの研究チームは、モデルがこれと同じパターンの周波数に対する感度を示すことを発見しました。

McDermott氏は話します。

「このモデルは、人がするのと同じように、周波数に依存する形で、両耳のタイミングとレベルの違いを利用しているようです。」

研究者らはまた、定位作業をより難しくするために、同時に再生する複数の音源を追加したところ、同じ状況下における人間の失敗パターンに近い形で、コンピュータモデルの性能が低下することを示しました。

フランシェル氏は話します。

「音源をどんどん増やしていくと、人間の音源の数を正確に判断する能力と、それらの音源を定位させる能力が、特定のパターンで低下していくのです。人間は、一度に約3つの音源を定位させるのが限界のようで、モデルで同じテストを行ったところ、本当に似たような行動パターンが見られました。」

研究者達は、モデルを訓練するために仮想世界を使ったので、モデルが様々なタイプの不自然な条件下で定位することを学習した時に何が起こるかを探ることも出来ました。

研究者たちは、反響のない仮想世界で1セットのモデルを訓練し、もう1セットは、一度に複数の音が聞こえることがない世界で訓練しました。

さらに、自然界に存在する音ではなく、狭い周波数帯域の音だけを聞かせたモデルもあります。

これらの非自然的な世界で訓練したモデルを、同じ行動テストで評価したところ、モデルは人間の行動から逸脱し、その逸脱の仕方は訓練した環境の種類によって異なっていました。

これらの結果は、人間の脳の定位能力が、人間が進化してきた環境に適応しているという考えを支持するものであると研究者は述べています。

研究者らは現在、この種のモデリングを、ピッチ知覚や音声認識など、聴覚の他の側面にも適用しています。

また、人が注意を払ったり記憶したりできることの限界など、他の認知現象の理解にも利用できると、McDermott氏は考えているそうです。

この研究は、全米科学財団と全米聴覚障害者研究所から資金提供を受けています。

この記事が気に入ったら

いいね または フォローしてね!

関連記事

新着記事

-

男女ともに長生きになる「男女平等」2023.03.07健康

男女ともに長生きになる「男女平等」2023.03.07健康 -

他者を犠牲にして利益を取る・利益を度外視して他者への害を取り除く2023.03.06人体・脳

他者を犠牲にして利益を取る・利益を度外視して他者への害を取り除く2023.03.06人体・脳 -

「寿命を延ばす」良質な睡眠2023.03.05健康

「寿命を延ばす」良質な睡眠2023.03.05健康 -

見極める力を養う「チャットボットの精度」2023.03.04技術

見極める力を養う「チャットボットの精度」2023.03.04技術 -

健康増進と生きがいにつながる「森林浴」2023.03.03健康

健康増進と生きがいにつながる「森林浴」2023.03.03健康 -

米国の6人に1人「肥満による死」2023.03.02健康

米国の6人に1人「肥満による死」2023.03.02健康 -

週休4日制で生産を維持する2023.03.01社会

週休4日制で生産を維持する2023.03.01社会 -

オンライン学習で学生に届く教育方法2023.02.28学習

オンライン学習で学生に届く教育方法2023.02.28学習 -

学業成績に影響を与える「夜間の睡眠」2023.02.27健康

学業成績に影響を与える「夜間の睡眠」2023.02.27健康 -

心の豊かさに大きく影響を与える「目的意識を持った10代の若者」2023.02.26健康

心の豊かさに大きく影響を与える「目的意識を持った10代の若者」2023.02.26健康

よく読まれている記事

-

なぜタイピングより手書きの方が、記憶に定着するのか

なぜタイピングより手書きの方が、記憶に定着するのか -

どんな曲が好き?「 音楽の好みと性格の関連性は普遍的 」

どんな曲が好き?「 音楽の好みと性格の関連性は普遍的 」 -

視覚と意思決定領域の結びつきが強い「鮮明なイメージ能力がある人」

視覚と意思決定領域の結びつきが強い「鮮明なイメージ能力がある人」 -

「触覚が敏感な部位はなぜあるのか」触覚メカニズムが解明される

「触覚が敏感な部位はなぜあるのか」触覚メカニズムが解明される -

不活性化されたリチウムイオン電池を甦えさせる「復活するリチウムイオン電池」

不活性化されたリチウムイオン電池を甦えさせる「復活するリチウムイオン電池」 -

記憶が脳に保存される新しい理論「MeshCODE理論」が開発される

記憶が脳に保存される新しい理論「MeshCODE理論」が開発される -

大面積有機フォトダイオードに置き換わる?「シリコンフォトダイオード技術」

大面積有機フォトダイオードに置き換わる?「シリコンフォトダイオード技術」 -

幸福度を7%上げる「旅行の仕方」

幸福度を7%上げる「旅行の仕方」 -

「世界最長寿記録を更新し132歳まで生きる人が出現する」ベイズ統計学予測

「世界最長寿記録を更新し132歳まで生きる人が出現する」ベイズ統計学予測 -

組織の中で行われたインシビリティ(非礼な言動)を軽視してはいけない理由

組織の中で行われたインシビリティ(非礼な言動)を軽視してはいけない理由

N E W S & P O P U L A R最 新 記 事 & 人 気 記 事

WHAT'S NEW !!

-

男女ともに長生きになる「男女平等」

【男女ともに長生きになる「男女平等」】 権利とは人間が作り出した構造ですが、男女平等が進むと男女ともに長生きになるようです。 The first global study to investi... -

他者を犠牲にして利益を取る・利益を度外視して他者への害を取り除く

【他者を犠牲にして利益を取る・利益を度外視して他者への害を取り除く】 他者を犠牲にして自分の利益を選ぶ、自分にとって利益は少ないが他者への害を防ぐ、道徳的なに... -

「寿命を延ばす」良質な睡眠

【「寿命を延ばす」良質な睡眠】 良質な睡眠をとることは、寿命を何年も長くする可能性があります。 Getting good sleep can play a role in supporting your heart and... -

見極める力を養う「チャットボットの精度」

【見極める力を養う「チャットボットの精度」】 ChatGPTをはじめ、チャットボットの精度は人が書いたものかどうかわからない程までの水準になっています。 The most rec...

-

なぜタイピングより手書きの方が、記憶に定着するのか

【なぜタイピングより手書きの方が、記憶に定着するのか】 ノルウェー科学技術大学の研究によると、手書きの方が物事をよく覚えることが判明しました。 様々なコンピュ... -

どんな曲が好き?「 音楽の好みと性格の関連性は普遍的 」

【どんな曲が好き?「 音楽の好みと性格の関連性は普遍的 」】 激しい音楽を好んで聴く人は、激しい性格の持ち主なのでしょうか?研究者は、音楽の好みと性格の関連性は... -

視覚と意思決定領域の結びつきが強い「鮮明なイメージ能力がある人」

【視覚と意思決定領域の結びつきが強い「鮮明なイメージ能力がある人」】 鮮明にイメージできる人は、視覚ネットワークと意思決定に関連する脳の領域が強く結びついてい...

News

- 新着記事 -

Popular

- 人気記事 -

H A P P I N E S S幸 福

人気 (❁´ω`❁)

M E A L食 事

B R A I N脳

人気 (❁´ω`❁)

H E A L T H健 康

人気 (❁´ω`❁)

-

人体・脳

健康な脳を保ち老化を遅らせる「アマゾンの先住民族ツィマネ族の生活習慣」

【健康な脳を保ち老化を遅らせる「アマゾンの先住民族ツィマネ族の生活習慣」】 ボリビア・アマゾンの先住民族であるツィマネ族が、アメリカやヨーロッパの人々に比べて... -

社会

自制心が健康と若さをもたらす理由

【自制心が健康と若さをもたらす理由】 デューク大学の研究チームは、自制心が心身に及ぼす影響を調査しました。 1000人を出生から45年間に渡って追跡した大規模調査で... -

健康

高強度インターバルトレーニングは、適度な運動よりも心臓を強化する

【心臓を強化する高強度インターバルトレーニング】 ノルウェー科学技術大学の研究によると、トレーニングの強度が、病気の重症度を軽減し、心臓機能を改善し、作業能力...

-

人体・脳

健康な脳を保ち老化を遅らせる「アマゾンの先住民族ツィマネ族の生活習慣」

【健康な脳を保ち老化を遅らせる「アマゾンの先住民族ツィマネ族の生活習慣」】 ボリビア・アマゾンの先住民族であるツィマネ族が、アメリカやヨーロッパの人々に比べて... -

社会

自制心が健康と若さをもたらす理由

【自制心が健康と若さをもたらす理由】 デューク大学の研究チームは、自制心が心身に及ぼす影響を調査しました。 1000人を出生から45年間に渡って追跡した大規模調査で... -

健康

高強度インターバルトレーニングは、適度な運動よりも心臓を強化する

【心臓を強化する高強度インターバルトレーニング】 ノルウェー科学技術大学の研究によると、トレーニングの強度が、病気の重症度を軽減し、心臓機能を改善し、作業能力...

J O B仕 事

人気 (❁´ω`❁)

-

社会

週休4日制で生産を維持する

-

人体・脳

アイデアや閃きが降りてくる「横断的なコミュニケーション」

-

社会

大災害を読み解く鋭い解決策

-

思考・瞑想

賞や表彰が発明家の創造性を低下させる

-

人体・脳

創造的な人はここが違う!「非創造的なハブを回避し非典型的なアプローチをする」

-

社会

アメリカ陸軍で既に多数の成功を収めている「人々を創造的にするトレーニング」

-

社会

2年は普及しない?「カテゴリーイノベーション戦略」

-

社会

管理者級以上必見「創造性を引き出す同僚間の友情とサポートを育む組織づくり」

-

社会

アイデアを創出する人数「少人数のグループのほうが新しいアイデアが出やすい」

-

健康

散った気を元の集中に戻す「1日最大50%費やす迷いを断つマインドフルネス」

-

社会

移動によるエネルギーが激減「環境に優しく誰でも参加できるオンライン会議」

-

社会

山火事コスト数十億ドルのコスト削減「インドネシアの泥炭地回復」

-

社会

価格末「99円」設定が販売者に不利益を及ぼす驚愕の理由

-

社会

購買意欲を掻き立てる商品提示方法

-

社会

「感情的異質性」がチームの創造性を高める

-

社会

従業員の創造性を高める驚愕の方法「報酬を選択制にする」

-

社会

テクノロジーの力でセレンディピティを生み出す

-

社会

様々なテーマの問題への取り組みにつながる「ダ・ヴィンチ構想」

-

社会

改善が必要な状況に「やめる」という解決策がでない理由

-

社会

空想が苦手な理由と、その修正方法

-

学習

パズル解きの極意、最良の選択より優れた驚愕の方法

-

社会

大麻が独創的で実現不可能なアイデアを創出するという実験結果

-

社会

記憶に残るユーモアを含んだニュース

-

社会

なぜメッセージと画像が一致してない情報は伝わらないのか

-

社会

消費者を購買に結びつける音楽

-

技術

自動化工場などの緊急事態に備えて知識を生かしておく方法

-

社会

「生産性も顧客満足度も向上」プロジェクトに自主性を持たせる

-

人体・脳

人は1日に35,000回の意思決定をしている「意思決定を行うアルゴリズム」

-

社会

他文化と頻繁衝突する文化圏は協力的なゲームが流行?「ゲームからみる文化」

-

社会

「通勤はわるいもの?」モバイルセンシングで仕事の成果と通勤の関連性を解明

-

社会

テクノロジーは労働者の幸福度にどのような影響を及ぼすか

-

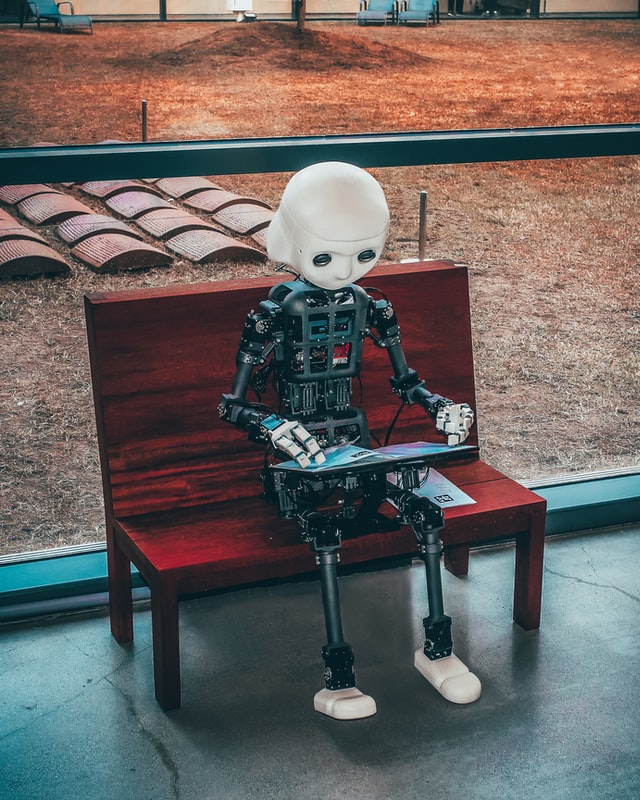

社会

雇用の創出ではなく雇用の置換が進む「ロボットなどの作業の自動化」

-

社会

「柔軟で弾力性のある対応が可能」生物系を模倣した多様なサプライチェーン

-

社会

「患者のメンタルヘルスケアを向上させる」患者と心理療法士のマッチング

-

学習

デジタルデバイス用に最適なフォント「AdaptiFont」

T E C H N O L O G Y技 術

人気 (❁´ω`❁)